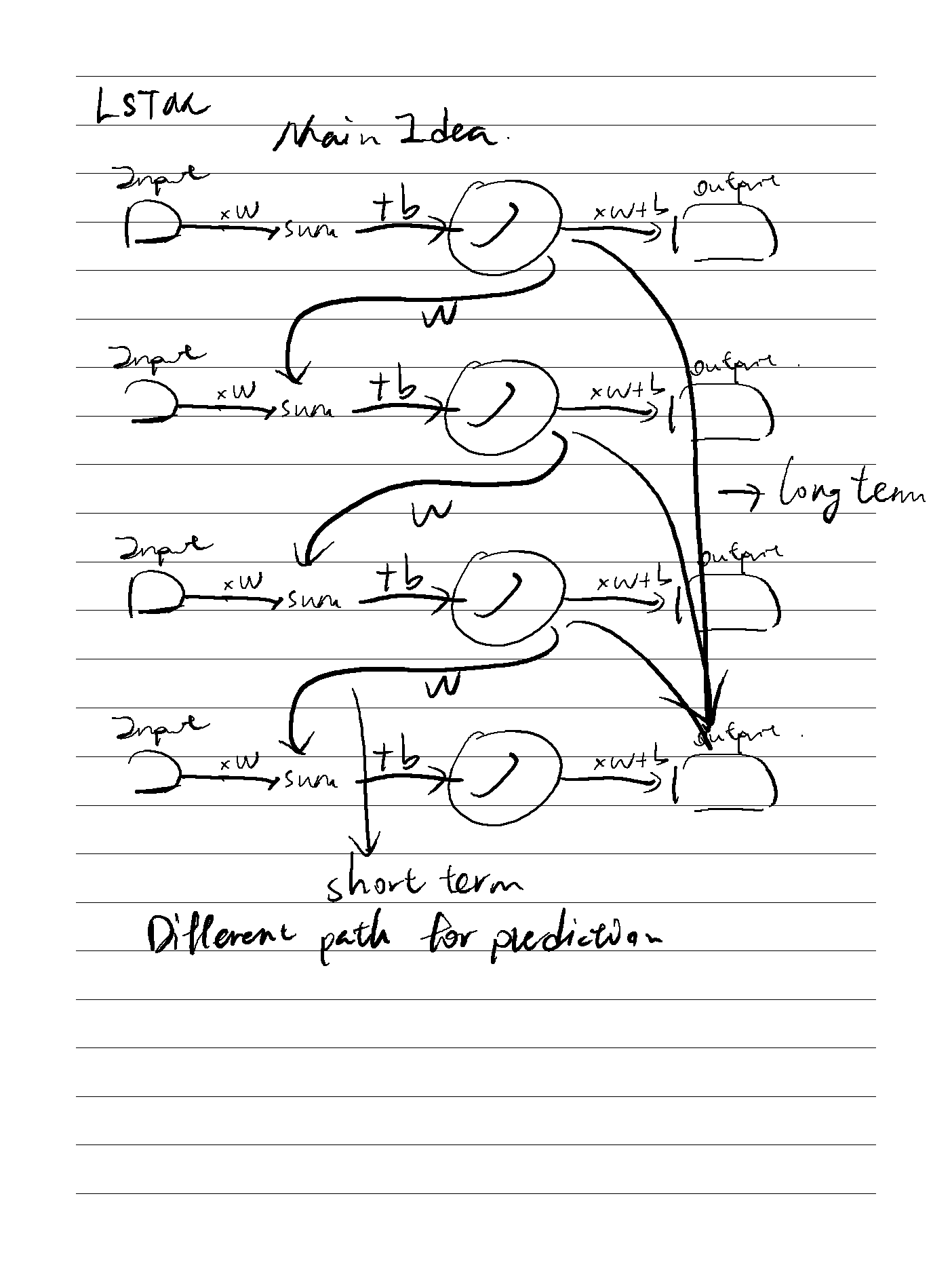

LSTM主要是用于解决递归网络中梯度指数级消失或者梯度爆炸的问题

On the Properties of Neural Machine Translation= Encoder–Decoder Approaches

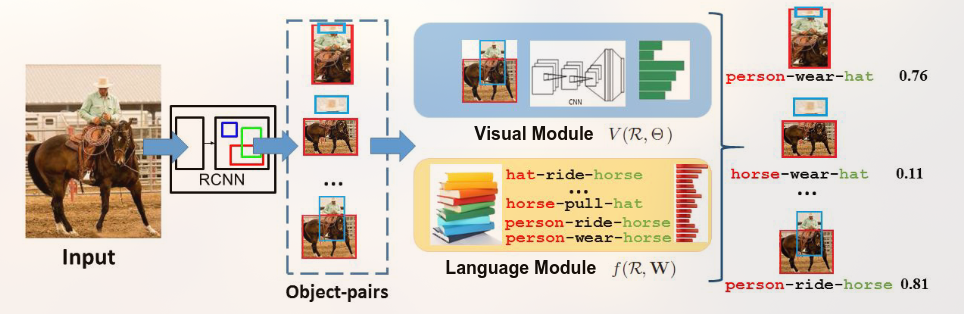

对比了 RNN Encoder-Decoder 和 GRU(new proposed)之间的翻译能力,发现GRU更具优势且能够理解语法。

Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling

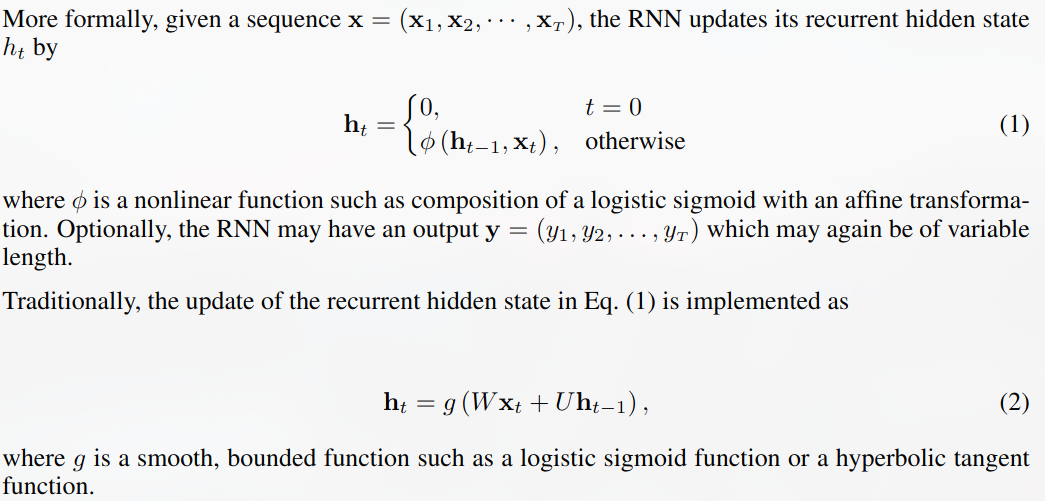

首先介绍了RNN通过hidden state来实现记忆力功能

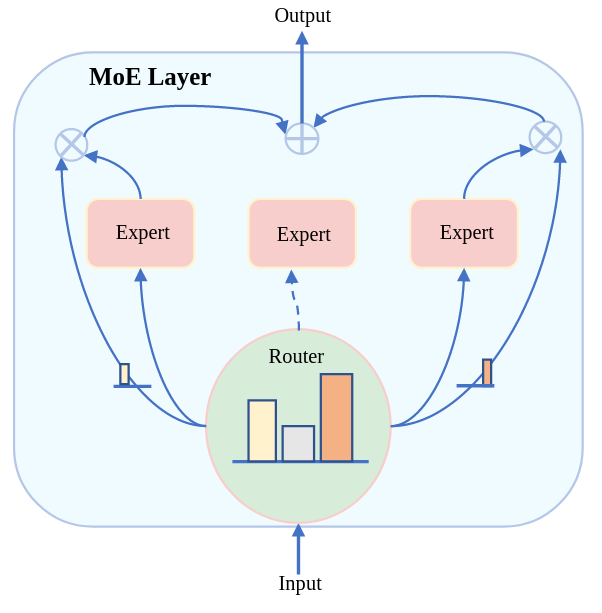

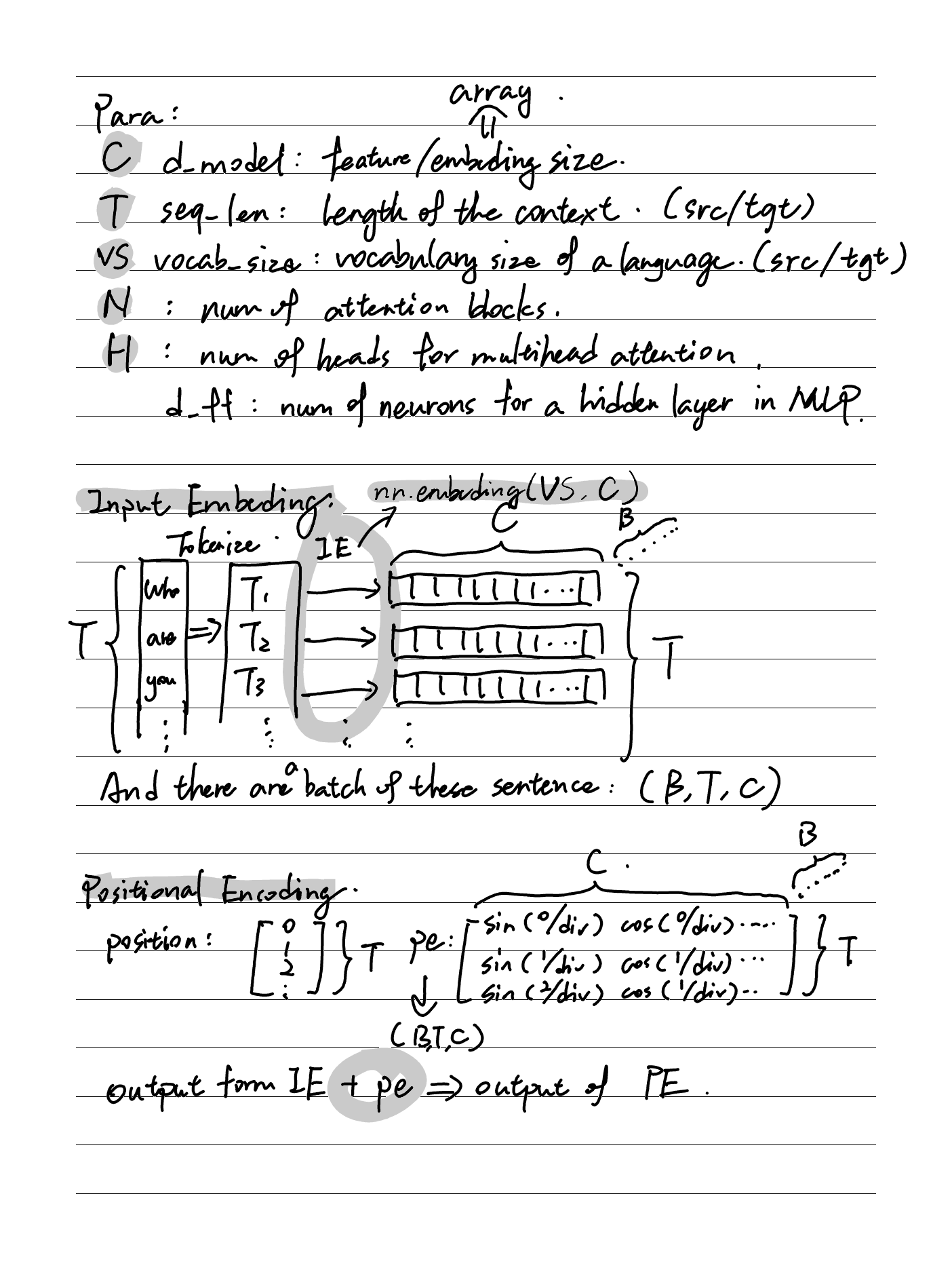

Transformer是一种基于注意力机制,完全不需要递归或卷积网络的序列预测模型,且更易于训练

Archives

- February 202614

- January 20268

- December 20253

- November 20256

- October 20251

- September 20253

- August 20256

- July 20255

- June 20256

- May 202510

- April 202517

- March 202545

- February 202512

- January 202513

- December 202412

- November 20244

- October 202418

- September 202416

- August 202413

- July 20243

- June 20245

- May 202413

- April 202417

- March 20241

- January 20241

- December 20231

- May 202346

- August 20221

- May 20226

- April 20229