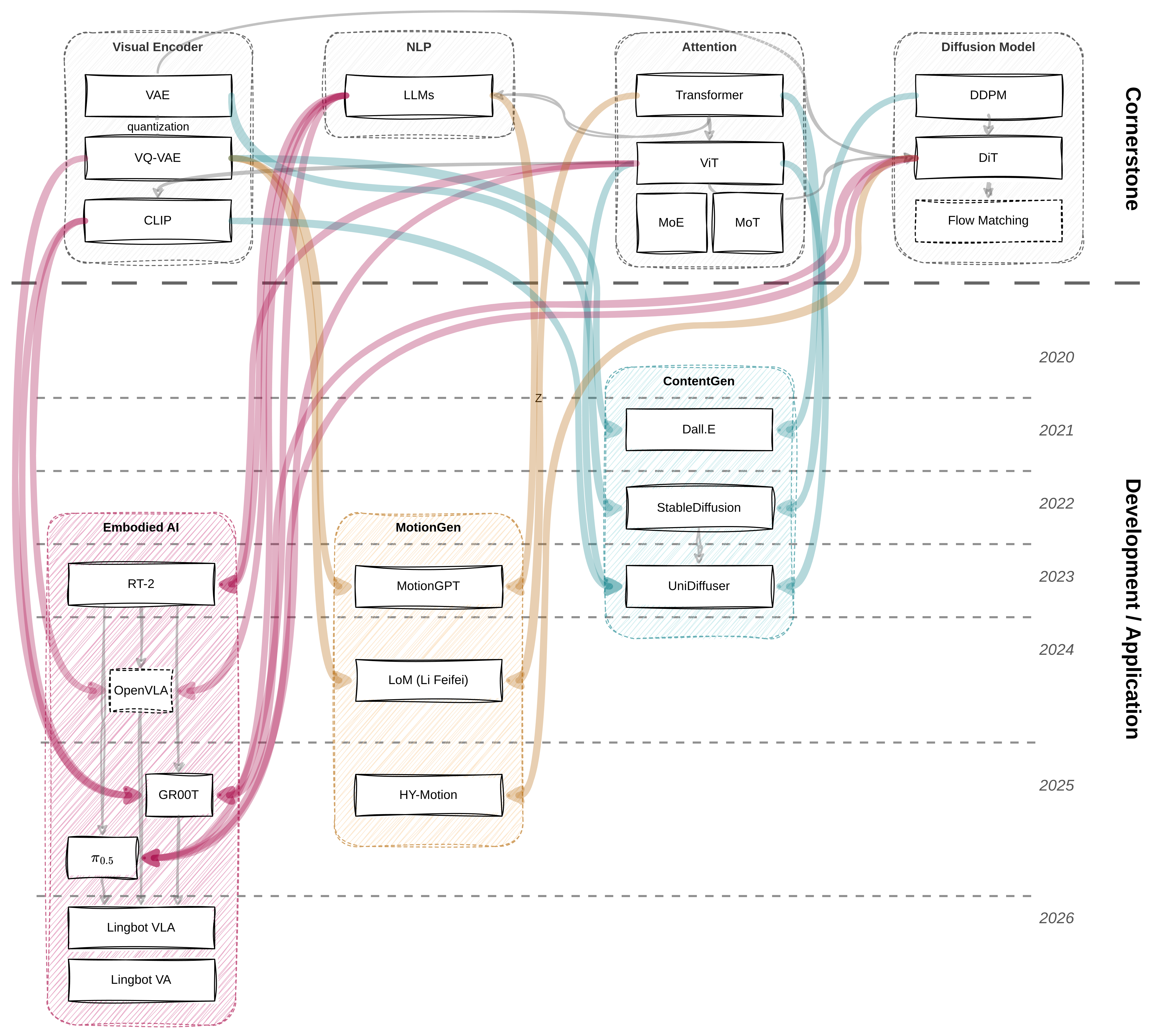

VLA背景论文调研

## 基石

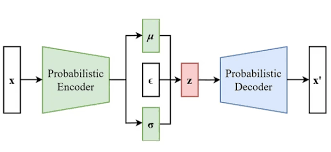

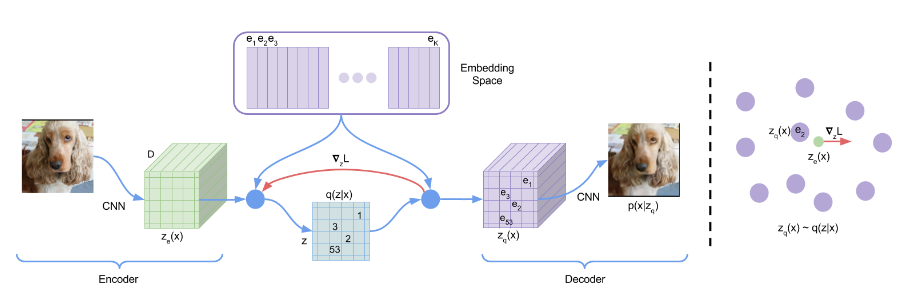

变分自编码器VAE/VQ-VAE

解决了什么问题:如何压缩数据,并从压缩后的特征中重新生成数据。

更具体一些,两者是将高维的高噪声数据压缩到低维的流形上(使用$\mathcal{D}$维的latent embedding来表示一个数据)。二者对于流形的构建方式不同: - VAE:连续且平滑,但生成的质量较为模糊(图像生成) - VQ-VAE: 使用离散的基元表示(可以认为压缩率更高,更抽象),生成质量更清晰注意力机制Self-Attention/Cross-Attention

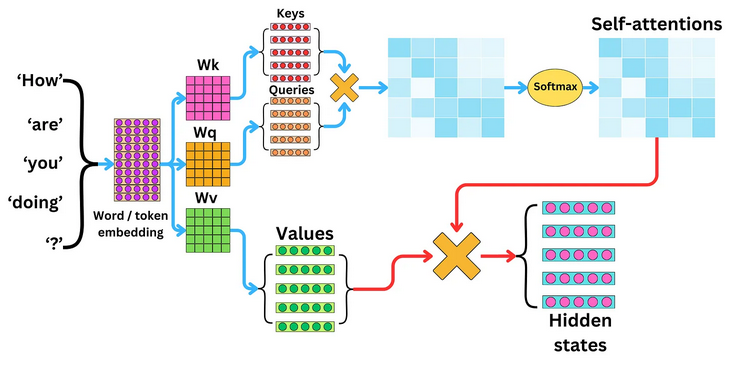

解决了什么问题:跨模态,长距离的序列理解和预测。

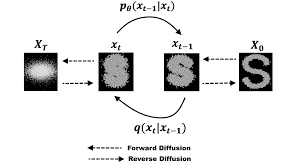

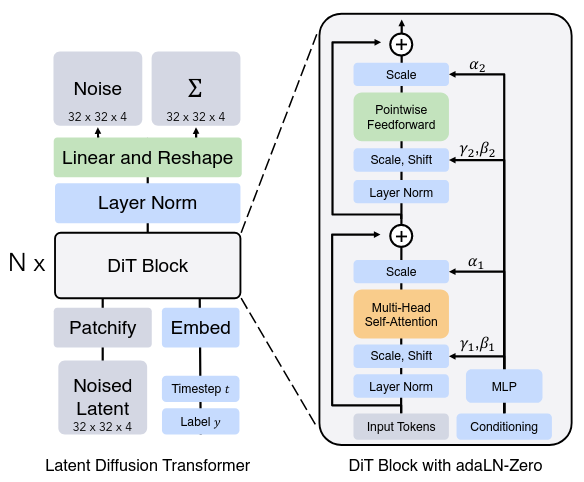

### Diffusion Model **解决了什么问题**:兼具高质量和多样性的生成模型。 核心方法: - **前向过程:** 给图像加噪。这是一个简单的马尔可夫链,直到图片完全变成纯高斯噪声。 - **反向过程:** 训练一个神经网络(通常是 U-Net,或者可以是Transformer),预测在t步时的噪声$\epsilon_t$ DiT是将DDPM的backbone从UNet换成DiT Block(Transformer encoder with adaLN) 达成更好生成效果的同时,可以通过控制adaLN的$\alpha, \gamma, \beta$来控制生成的目标。内容生成-图片&文字

主要是基于Diffusion Model的应用,引入了多模态。例如Stable Diffusion结合了CLIP的text encoder和KL-VAE的图像潜空间。