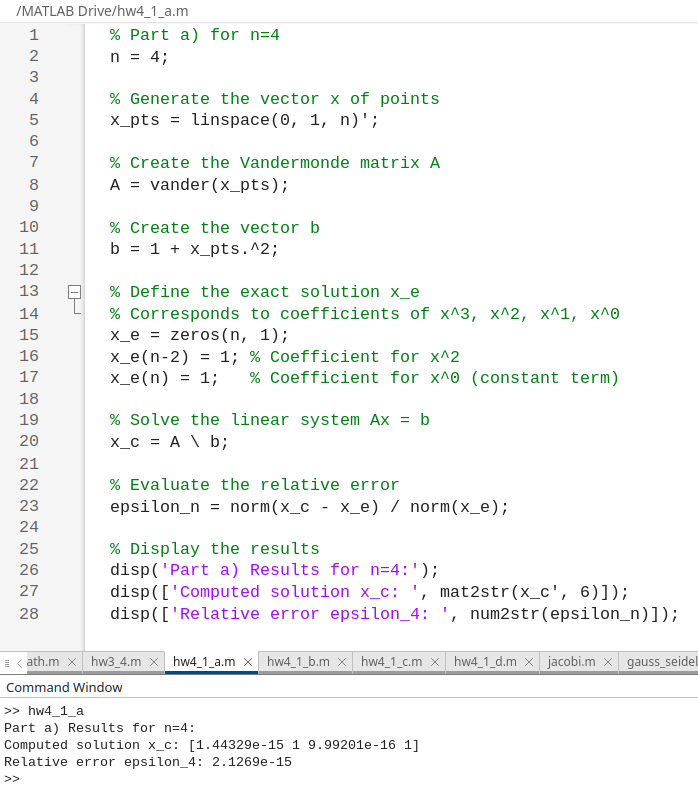

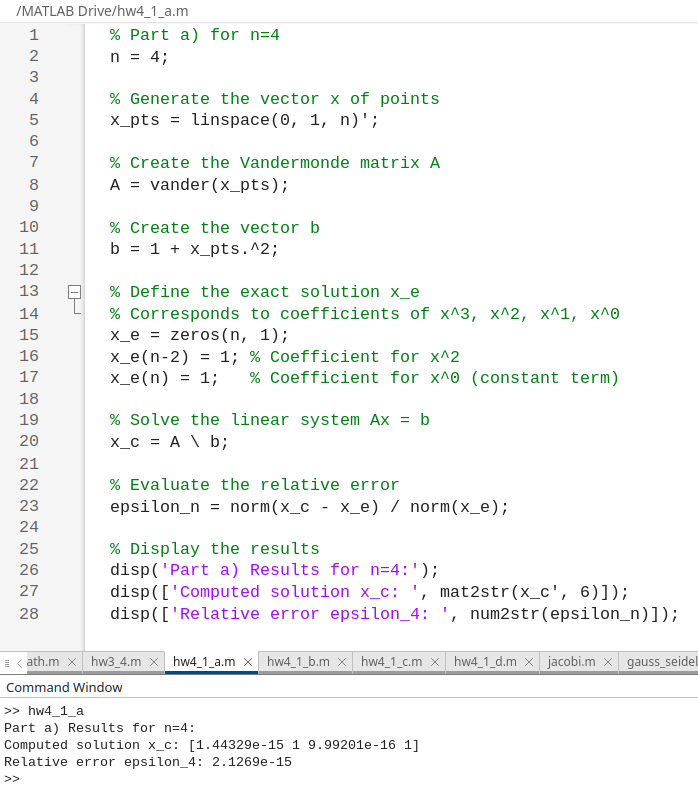

The result of hw4_1_a.m:

The result of hw4_1_a.m:

The objective is to find the coefficients $(\alpha, \beta, \gamma)$ for the finite difference formula:

$$

D_{h}f(\overline{x})=\frac{\alpha f(\overline{x})+\beta f(\overline{x}-h)+\gamma f(\overline{x}-2h)}{h} \quad

$$

The analysis begins by substituting the Taylor series expansions for $f(\overline{x}-h)$ and $f(\overline{x}-2h)$ around the point $\overline{x}$ into the formula.

01:

01:

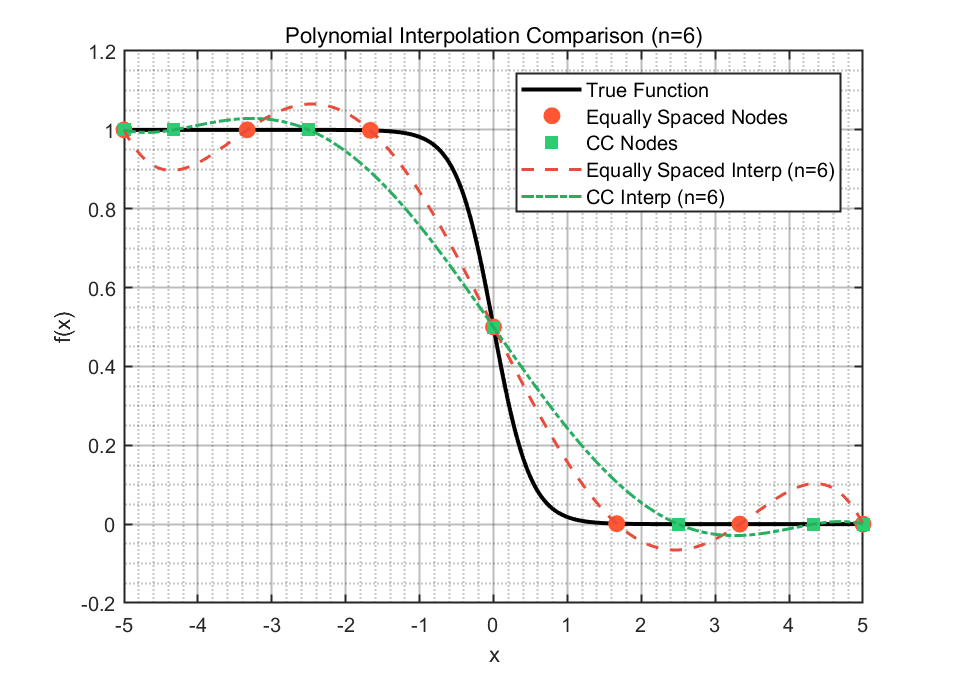

To approximate the function $$f(x) = \frac{1}{1 + \exp(4x)} $$on the interval [-5, 5], polynomial interpolation was performed using polynomials of degree n=6 and n=14. Two types of nodes were considered: equally spaced nodes and Clenshaw-Curtis nodes, the latter computed using the formula

Repository:

https://github.com/PSGBOT/pixtral-12B-Inference

1 | def encode_image(image_path): |

核心需要:准确定位物体所在方位,不把远景识别为物体,降低False Positive

1 | Focus on the area highlighted in green in the image. |

输出结果:

1 | Valid: Yes |

1 | Valid: No |

使用另一个LLM来对VLM输出的内容进行parse,转化成json文件, 通过mistral ai 提供的接口实现:

1 | class Instance(BaseModel): |

使用mpm安装(https://wiki.archlinux.org/title/MATLAB)

Download mpm from https://www.mathworks.com/mpm/glnxa64/mpm and make it executable.

安装:

1 | ./mpm install --release=R2024b --destination=/home/cyl/matlab MATLAB |

安装后启动完成lisense注册后使用patch(https://bbs.archlinux.org/viewtopic.php?id=303177)

1 | patchelf --clear-execstack /home/user/.MathWorks/ServiceHost/-mw_shared_installs/v2024.13.0.2/bin/glnxa64/libmwfoundation_crash_handling.so |

如果出现空白窗口左下显示ready,那么参考(www.reddit.com/r/matlab/comments/1dhejp5/matlab_gui_not_loading_properly_on_arch/),设置环境变量

1 | export _JAVA_AWT_WM_NONREPARENTING=1 |

Part-level Dataset Available for Augmentation

Single Instance

Complicated Scene

from shelves_dataset 3000 images -> ? train & ? val samples

from desk_dataset 699 images -> ? train & ? val samples

from tool_dataset (simplified) 1335 images -> 2729 train & 911 val samples

from 130k Images/furniture 1983 images -> ? train & ? val samples

from coco2017 2212 images -> ? train & ? val samples

current total: