使用的backbone是BERT(通过MLM训练)

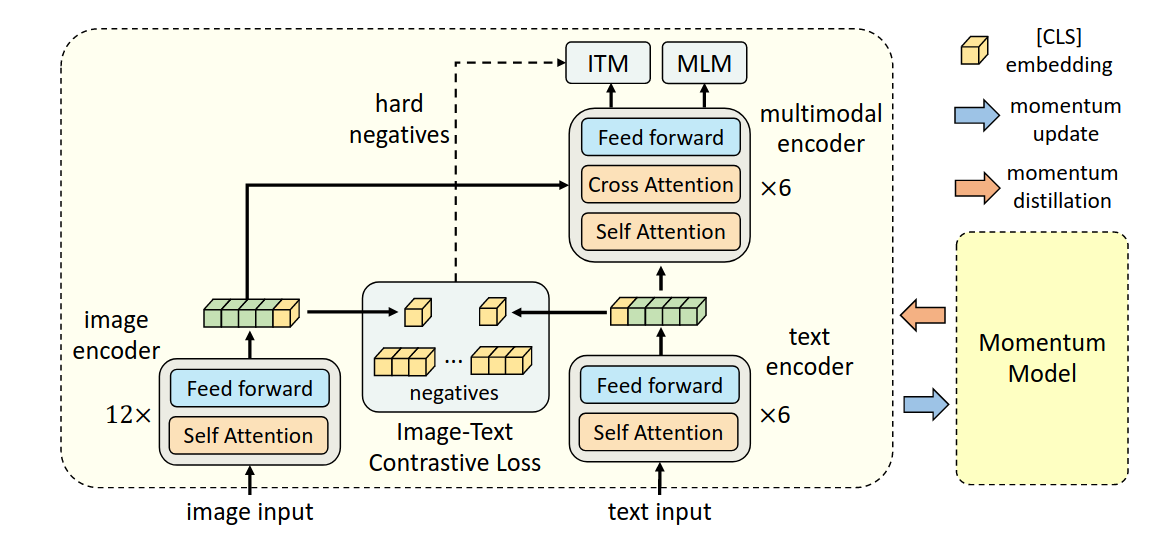

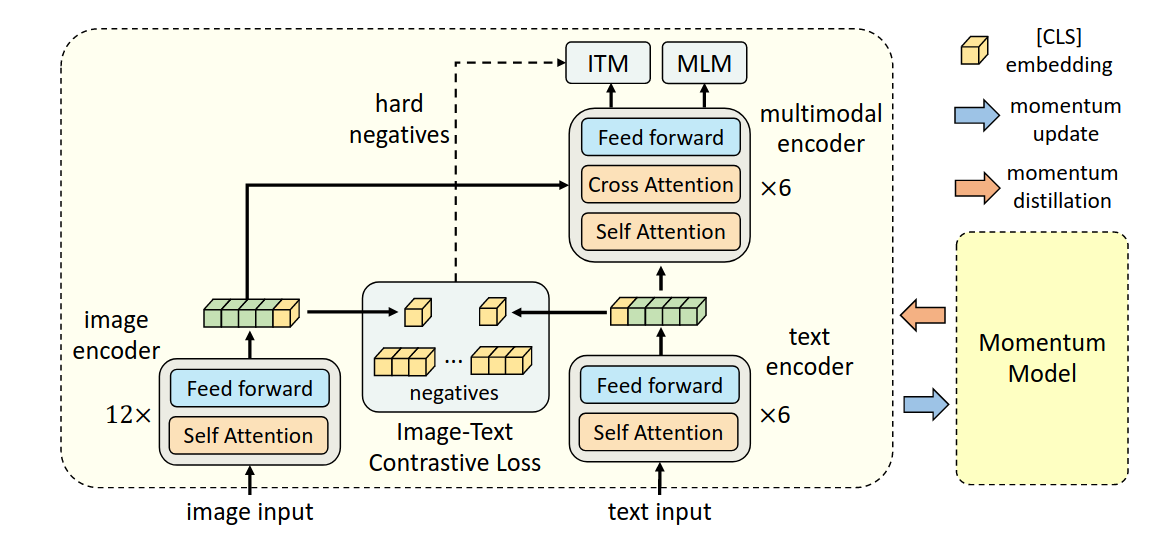

该研究认为,image encoder的模型大小应该大于text encoder,所以在text encoder这里,只使用六层self attention来提取特征,剩余六层cross attention用于multi-modal encoder。

使用的backbone是BERT(通过MLM训练)

该研究认为,image encoder的模型大小应该大于text encoder,所以在text encoder这里,只使用六层self attention来提取特征,剩余六层cross attention用于multi-modal encoder。

A vision-language model that unifies vision-language understanding and generation tasks.